Notice

Recent Posts

Recent Comments

Link

- Today

- Total

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

Tags

- AI

- 모두의연구소

- 개념정리

- 프로젝트

- Jupyter Notebook

- 데이터

- error

- 데이터사이언티스트

- 머신러닝

- 파이썬

- bigquery

- python

- 회고

- ML

- 부트캠프

- 데이터사이언스

- 딥러닝

- sql

- 회고록

- 함수

- 2주차

- 딕셔너리

- 변수

- 깃허브

- 주피터노트북

- data

- 빅쿼리

- 1주차

- github

- 파이썬문법

Archives

[딥러닝] 딥러닝 알아보기2 - 텐서 생성, 텐서 타입, 텐서 타입 변환, 텐서 연산, 다양한 함수 정리 본문

반응형

🛠 Tensor? 텐서란?

딥러닝에서 데이터를 표현하고 계산하기 위한 기본 단위로

딥러닝 연산은 모두 텐서 연산으로 이루어진다.

텐서의 차원에 따라 이름이 다르다.

| 텐서 차원 | 설명 | 예시 | 실제 상황 비유 |

| 0차원 (스칼라) | 숫자 하나, 크기 없음 | 5, 3.14 | 온도계의 현재 온도 22도 |

| 1차원 (벡터) | 숫자들의 나열, 선형 배열 | [5, 7, 9] | 시험 점수 리스트: 수학, 영어, 과학 |

| 2차원 (행렬) | 행과 열이 있는 데이터 테이블 | [[1, 2], [3, 4]] | 엑셀 표처럼 (학생 x 과목 점수) |

| 3차원 (큐브) | 여러 개의 행렬 → 종이 뭉치 느낌 | [[[1,2], [3,4]], [[5,6], [7,8]]] | 흑백 이미지 여러 장 (예: 100장의 28x28 사진) |

| 4차원 | 각 데이터마다 채널까지 포함된 구조 | (batch, channel, height, width) | RGB 컬러 이미지 100장(100장 × 3채널 × 28×28 픽셀) |

| 5차원 | 시퀀스나 시간 요소가 있는 경우 | (batch, time, channel, height, width) (10, 100, 3, 28, 28) |

10개의 비디오(=시퀀스)각 비디오에 100프레임각 프레임은 RGB 이미지 |

🔥텐서 생성

| 함수/메서드 | 기능 요약 |

| tf.constant(value) | 입력값으로부터 TensorFlow 텐서 생성 |

| tf.rank(tensor) | 텐서의 차원(축의 개수) 반환 |

t0 = tf.constant(1)

print(t0)

print(tf.rank(t0))

# tf.Tensor(1, shape=(), dtype=int32)

# tf.Tensor(0, shape=(), dtype=int32)

t1 = tf.constant([1, 2, 3])

print(t1)

print(tf.rank(t1))

# tf.Tensor([1 2 3], shape=(3,), dtype=int32)

# tf.Tensor(1, shape=(), dtype=int32)

t2 = tf.constant([[1, 2, 3],

[4, 5, 6],

[7, 8, 9]])

print(t2)

print(tf.rank(t2))

# tf.Tensor(

# [[1 2 3]

# [4 5 6]

# [7 8 9]], shape=(3, 3), dtype=int32)

# tf.Tensor(2, shape=(), dtype=int32)

t3 = tf.constant([

[[1, 2, 3],

[4, 5, 6],

[7, 8, 9]],

[[1, 2, 3],

[4, 5, 6],

[7, 8, 9]],

[[1, 2, 3],

[4, 5, 6],

[7, 8, 9]]

])

print(t3)

print(tf.rank(t3))

# tf.Tensor(

# [[[1 2 3]

# [4 5 6]

# [7 8 9]]

#

# [[1 2 3]

# [4 5 6]

# [7 8 9]]

#

# [[1 2 3]

# [4 5 6]

# [7 8 9]]], shape=(3, 3, 3), dtype=int32)

# tf.Tensor(3, shape=(), dtype=int32)

i = tf.constant(2)

print(i)

# tf.Tensor(2, shape=(), dtype=int32)

f = tf.constant(2.)

print(f)

# tf.Tensor(2.0, shape=(), dtype=float32)

s = tf.constant('Seoul')

print(s)

# tf.Tensor(b'Seoul', shape=(), dtype=string)

f16 = tf.constant(2., dtype=tf.float16)

print(f16)

# tf.Tensor(2.0, shape=(), dtype=float16)

i8 = tf.constant(2, dtype=tf.int8)

print(i8)

# tf.Tensor(2, shape=(), dtype=int8)

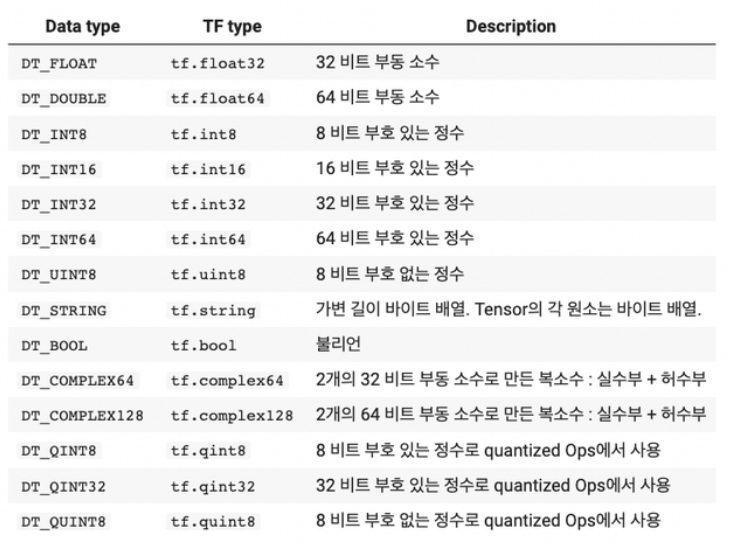

🔥텐서 타입

🔥텐서 타입 변환

f32 = tf.cast(f16, tf.float32)

print(f32)

# tf.Tensor(2.0, shape=(), dtype=float32)

i32 = tf.cast(i8, tf.int32)

print(f32)

# tf.Tensor(2.0, shape=(), dtype=float32)

🔥텐서의 연산

서로 다른 타입을 가지는 텐서는 연산이 되지 않고 에러 발생

따라서 타입을 동일하게 변환해주어야 함

| 연산 기호 | TensorFlow 함수 | 설명 |

| + | tf.add() | 더하기 연산 |

| - | tf.subtract() | 빼기 연산 |

| * | tf.multiply() | 곱하기 연산 |

| / | tf.divide() | 나누기 연산 |

| @ | tf.matmul() | 행렬곱 연산 |

| - | tf.reduce_max() | 텐서 값 중 최대값 |

| - | tf.argmax() | 최대값의 위치(인덱스) 반환 |

# 0차원 텐서 연산

print(tf.constant(2) + tf.constant(2))

print(tf.constant(2) - tf.constant(2))

print(tf.add(tf.constant(2), tf.constant(2)))

print(tf.subtract(tf.constant(2), tf.constant(2)))

# tf.Tensor(4, shape=(), dtype=int32)

# tf.Tensor(0, shape=(), dtype=int32)

# tf.Tensor(4, shape=(), dtype=int32)

# tf.Tensor(0, shape=(), dtype=int32)

print(tf.constant(2) * tf.constant(2))

print(tf.constant(2) / tf.constant(2))

print(tf.multiply(tf.constant(2), tf.constant(2)))

print(tf.divide(tf.constant(2), tf.constant(2)))

# tf.Tensor(4, shape=(), dtype=int32)

# tf.Tensor(1.0, shape=(), dtype=float64)

# tf.Tensor(4, shape=(), dtype=int32)

# tf.Tensor(1.0, shape=(), dtype=float64)

# 서로 다른 타입을 가지는 텐서는 연산이 되지 않고 에러 발생

print(tf.constant(2) + tf.constant(2.2))

# error

# 따라서 타입을 동일하게 변환해주어야 함

print(tf.cast(tf.constant(2), tf.float32) + tf.constant(2.2))

# tf.Tensor(4.2, shape=(), dtype=float32)

# 1차원 텐서 연산

a = tf.constant([1])

b = tf.constant([1])

print(a)

print(b)

# tf.Tensor([1], shape=(1,), dtype=int32)

# tf.Tensor([1], shape=(1,), dtype=int32)

print(a+b)

print(a-b)

print(a * b)

print(a / b)

# tf.Tensor([2], shape=(1,), dtype=int32)

# tf.Tensor([0], shape=(1,), dtype=int32)

# tf.Tensor([1], shape=(1,), dtype=int32)

# tf.Tensor([1.], shape=(1,), dtype=float64)

# 2차원 텐서의 연산

a = tf.constant([[1, 2, 3],

[4, 5, 6]])

b = tf.constant([[7,8],

[9,10],

[11,12]])

print(a)

print(b)

# tf.Tensor(

# [[1 2 3]

# [4 5 6]], shape=(2, 3), dtype=int32)

# tf.Tensor(

# [[ 7 8]

# [ 9 10]

# [11 12]], shape=(3, 2), dtype=int32)

print(a @ b) # matrix multiplication

# tf.Tensor(

# [[ 58 64]

# [139 154]], shape=(2, 2), dtype=int32)

print(tf.matmul(a, b))

# tf.Tensor(

# [[ 58 64]

# [139 154]], shape=(2, 2), dtype=int32)

c = tf.constant([[4.0, 5.0, 6.0],

[10.0, 9.0, 8.0]])

print(tf.reduce_max(c))

print(tf.argmax(c))

print(tf.nn.softmax(c))

# tf.Tensor(10.0, shape=(), dtype=float32)

# tf.Tensor([1 1 1], shape=(3,), dtype=int64)

# tf.Tensor(

# [[0.09003057 0.24472848 0.6652409 ]

# [0.6652409 0.24472848 0.09003057]], shape=(2, 3), dtype=float32)

🔥텐서의 다양한 함수들

https://docs.pytorch.org/tutorials/beginner/introyt/tensors_deeper_tutorial.html

| 함수 / 코드 | 설명 | 예시 코드 | 결과 설명 |

| tf.transpose(tensor) | 텐서의 차원 순서를 바꿔서 전치 | tf.transpose([[1, 2], [3, 4]]) | 2x2 행렬을 전치해서 (2,2) 크기 유지 |

| tf.reshape(tensor, shape) | 전체 원소 수를 유지한 채 텐서 모양 변경 | tf.reshape([1,2,3,4,5,6], (2,3)) | 1차원 (6,) → 2차원 (2,3) |

| tf.squeeze(tensor) | 차원이 1인 축을 제거 (압축) | tf.squeeze([[[1], [2], [3]]]) | (3,1) → (3,) |

| tf.expand_dims(tensor, axis) | 지정한 위치에 1차원 축 추가 | tf.expand_dims([1, 2, 3], axis=1) | (3,) → (3,1) |

| tf.split(tensor, num_or_size_splits, axis) | 텐서를 지정한 축을 기준으로 분할 | tf.split([1,2,3,4], num_or_size_splits=2, axis=0) | [ [1,2], [3,4] ] |

| tf.concat(values, axis) | 여러 텐서를 지정한 축 기준으로 연결 | tf.concat([[1,2], [3,4]], axis=0) | [1,2,3,4] |

'Deep Learning' 카테고리의 다른 글

| [딥러닝] 텍스트의 분포로 벡터화 하기(BoW, DTM&코사인 유사도, TF-IDF, LSA&LDA, soynlp) (0) | 2025.06.16 |

|---|---|

| [딥러닝] 텍스트 데이터를 문자열로 저장하기, 파일과 디렉터리 (4) | 2025.06.14 |

| [딥러닝] 딥러닝 알아보기1 - 인공 신경망, 퍼셉트론, 은닉층, 딥러닝 문제점 및 해결 방법 (1) | 2025.06.12 |